Inhaltsverzeichnis

- Die Herausforderung: Wenn dein AI-Assistent die neuesten Technologien nicht kennt

- Retrieval-Augmented Generation (RAG): Dein wichtigstes Werkzeug

- Context Engineering: Mehr als nur gute Prompts

- Multi-Model-Strategie: Nutze die Stärken verschiedener KI-Modelle

- Die besten Tools für moderne KI-gestützte Entwicklung

- Best Practices für den Entwicklungs-Workflow

- Herausforderungen meistern

- Zukunftsausblick: Emerging Technologies

- Fazit: Deine Action Items

- Referenzen

Die Herausforderung: Wenn dein AI-Assistent die neuesten Technologien nicht kennt

Entwickler stehen heute vor einem Paradoxon: Während KI-Assistenten wie Claude, ChatGPT und GitHub Copilot die Produktivität revolutionieren, kennen sie die neuesten Framework-Versionen oft nicht. Large Language Models (LLMs) werden mit statischen Datensätzen trainiert, die Monate oder Jahre alt sein können. Das bedeutet: Wenn Du mit Next.js 15, React 19 oder dem neuesten Python-Framework arbeitest, könnte dein AI-Assistent noch Lösungen aus der Steinzeit vorschlagen.

Diese „Knowledge Gap“ ist besonders problematisch in der schnelllebigen JavaScript- und Web-Development-Welt, wo Updates im Wochenrhythmus erscheinen [1]. Doch es gibt bewährte Strategien und Tools, mit denen Du trotzdem effektiv KI-gestützt entwickeln kannst.

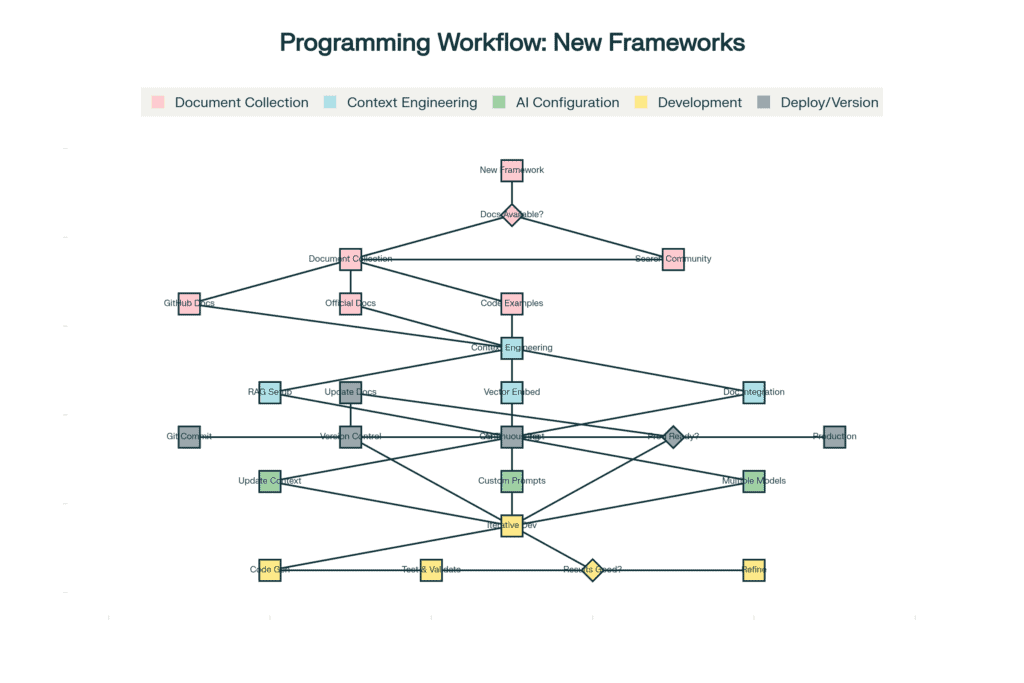

Workflow für Programmierung mit neuen Frameworks trotz veralteter LLM-Trainingsdaten

Retrieval-Augmented Generation (RAG): Dein wichtigstes Werkzeug

Was ist RAG und warum brauchst Du es?

RAG-Systeme sind die effektivste Methode, um LLMs mit aktuellen Informationen zu versorgen [2, 3]. Statt sich nur auf das begrenzte Wissen des LLMs zu verlassen, holen RAG-Systeme aktuelle Informationen aus externen Quellen und fügen sie direkt in den Kontext ein.

So funktioniert RAG in vier Schritten: [4]

- Indexierung: Die aktuelle Framework-Dokumentation wird in Vektor-Embeddings umgewandelt und gespeichert

- Retrieval: Basierend auf deiner Anfrage werden relevante Dokumentationsabschnitte abgerufen

- Augmentation: Die gefundenen Informationen werden mit deinem ursprünglichen Prompt kombiniert

- Generation: Das LLM erstellt Antworten basierend auf beiden Quellen

Tools für RAG-Implementierung

Für die praktische Umsetzung stehen dir verschiedene Vector-Databases zur Verfügung [5, 6]:

- Pinecone: Cloud-basierte Vector-Database mit exzellentem Support

- ChromaDB: Open-Source-Alternative, perfekt für lokale Entwicklung

- pgvector: PostgreSQL-Extension für bestehende Infrastrukturen

Praxis-Tipp: Beginne mit ChromaDB für erste Experimente. Es lässt sich mit wenigen Zeilen Python-Code einrichten und ist kostenlos.

Context Engineering: Mehr als nur gute Prompts

Context Engineering geht weit über klassisches Prompting hinaus und erstellt umfassende Informationsumgebungen für AI-Modelle [7, 8].

Die vier Säulen des Context Engineering

1️⃣ Information Layers: Strukturiere deinen Kontext in Schichten – von generellen Framework-Infos bis zu projektspezifischen Patterns

2️⃣ Dynamic Updates: Aktualisiere den Kontext automatisch bei Änderungen

3️⃣ Relevance Filtering: Priorisiere wichtige Informationen und filtere unwichtige Details

4️⃣ Validation Mechanisms: Stelle sicher, dass die bereitgestellten Informationen korrekt sind

Moderne Development-Tools mit Context Engineering

Tools wie VS Code haben bereits leistungsstarke Context-Engineering-Features eingebaut [9]. Mit der richtigen Extension kannst Du:

- Projektweite Code-Patterns definieren

- Automatisch Implementierungspläne generieren

- Code basierend auf aktuellen Framework-Richtlinien erstellen lassen

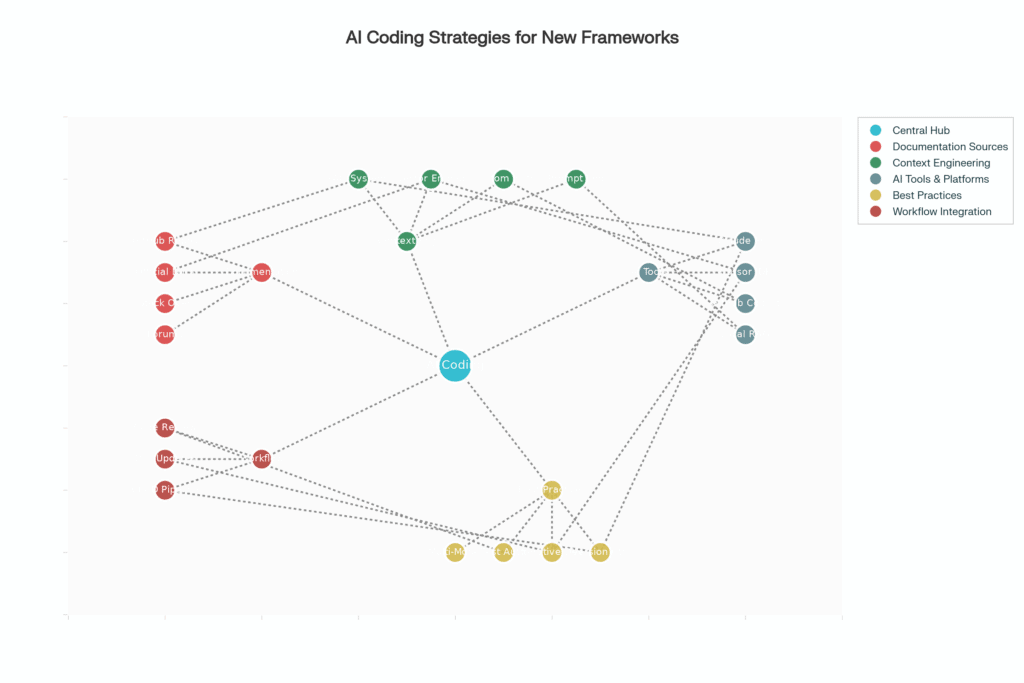

Multi-Model-Strategie: Nutze die Stärken verschiedener KI-Modelle

Nicht jedes LLM ist für jede Aufgabe gleich gut geeignet. Eine intelligente Multi-Model-Strategie maximiert deine Produktivität [10, 11].

Modell-Spezialisierungen

| Modell | Hauptstärke | Best Use Case |

|---|---|---|

| Claude Sonnet | Komplexes Debugging & Code-Reasoning | Architekturentscheidungen |

| GPT-4 | Schnelle Code-Generierung | Prototypen & schnelle Implementierung |

| Gemini | Dokumentation & Erklärungen | Code-Kommentare & Tutorials |

Workflow-Beispiel: Nutze Claude für Architekturentscheidungen, GPT-4 für schnelle Prototypen und spezialisierte Modelle für spezifische Frameworks.

Plattformen wie OpenRouter oder LiteLLM ermöglichen nahtlose Integration mehrerer Modelle, sodass automatisch das beste Modell für jede Aufgabe ausgewählt wird [11].

Abbildung 2: Überblick über Strategien und Tools für AI-gestützte Entwicklung – vom zentralen Coder-Hub über Dokumentationsquellen bis hin zu Best Practices

Die besten Tools für moderne KI-gestützte Entwicklung

Claude Projects mit GitHub-Integration

Claude Projects bieten eine der fortschrittlichsten Implementierungen für die Arbeit mit aktuellen Codebases [12, 13]:

Workflow:

- GitHub-Repository verbinden

- Relevante Dateien und Ordner auswählen

- Fokussierte Diskussion über spezifische Aufgaben

- Änderungen direkt zu GitHub pushen

- Project Knowledge automatisch aktualisieren

💡 Der große Vorteil: Claude analysiert deine gesamte Codebase und versteht den Kontext deines Projekts, selbst wenn es neueste Framework-Versionen verwendet.

Cursor IDE: Der AI-native Code-Editor

Cursor reimaginiert die Code-Editor-Erfahrung komplett neu [14, 15]:

- Codebase Intelligence: Erkennt architektonische Patterns in deinem gesamten Projekt

- Konsistenz-Checks: Identifiziert Abweichungen von etablierten Konventionen

- Pattern Learning: Lernt von deinem Code-Stil und schlägt konsistente Implementierungen vor

✨ Besonders wertvoll: Auch wenn das LLM ein Framework nicht kennt, lernt Cursor aus deiner Codebase und schlägt passende Lösungen vor.

GitHub Copilot mit erweiterten Features

Die neueste Copilot-Version unterstützt Multiple AI Models (GPT-4o, Claude 3.5 Sonnet, Gemini 2.0 Flash) [14]. Du kannst je nach Aufgabe das optimale Modell wählen.

Neue Features:[16]

- Chat-Funktionen für Code-Erklärungen

- Command-Line Interface für Terminal-Aufgaben

- Integration mit GitHub-Ökosystem (Issues, Pull Requests)

Best Practices für den Entwicklungs-Workflow

1. Dokumentations-First Entwicklung

Bevor Du Code generierst, sammle systematisch aktuelle Dokumentation [17, 18]:

Primäre Quellen:

- Offizielle Framework-Dokumentation

- GitHub Repositories der Frameworks

- Release Notes und Migration Guides

Sekundäre Quellen:

- Community-Tutorials

- Stack Overflow Discussions

- Blog Posts von Framework-Entwicklern

🎯 Pro-Tipp: Diese Informationen werden dann in Vektor-Embeddings umgewandelt und in einer durchsuchbaren Datenbank gespeichert [5, 19].

2. Iterative Entwicklung mit Feedback-Loops

Folge einem strukturierten Plan-Create-Test-Deploy-Zyklus [17, 20]:

- Planning: Klare, spezifische Aufgabendefinition mit aktueller Dokumentation als Kontext

- Creation: AI-generierter Code mit kontinuierlicher Validierung

- Testing: Automatisierte Tests und manuelle Validierung

- Deployment: Integration in die bestehende Codebase

⚠️ Kritisch: Jede AI-Antwort muss validiert werden. Fehler fließen als Feedback in nachfolgende Prompts ein [21, 17].

3. Version Control für AI-Workflows

Neben traditionellem Code-Versioning solltest Du auch versionieren [22, 23]:

- Prompts und Prompt-Templates

- AI-Konfigurationen

- Kontext-Definitionen

GitOps für AI Development:

- Prompts in Git verwalten

- Automated Testing für AI-generierten Code

- CI/CD Pipelines mit AI-Integration

- Dokumentation automatisch bei Framework-Updates aktualisieren

Herausforderungen meistern

Qualitätskontrolle von AI-generiertem Code

AI-generierter Code erfordert rigorose Qualitätskontrolle [24, 25].

- Veraltete Syntax

- Deprecated APIs

- Suboptimale Patterns

- Sicherheitslücken

Lösungsstrategien:

- Automated Linting und Code Formatting

- Comprehensive Testing (Unit, Integration, E2E)

- Code Review Prozesse mit AI-assistierter Analyse

- Documentation-Driven Development

AI-Halluzinationen vermeiden

AI-Halluzinationen sind besonders problematisch bei neuen Frameworks. Das Modell „erfindet“ APIs oder Funktionen, die nicht existieren [1, 26].

Mitigation Strategies:

- Strikte Validierung aller AI-Vorschläge gegen aktuelle Dokumentation

- Multiple Sources Confirmation für kritische Details

- Incremental Implementation mit kontinuierlichem Testing

- Human Oversight bei architektonischen Entscheidungen

Performance-Optimierung

RAG-Systeme können ressourcenintensiv sein [7, 27].

- Selective Context Loading: Nur relevante Code-Bereiche laden

- Caching Strategies: Häufig verwendete Embeddings cachen

- Hierarchical Context Organization: Nach Wichtigkeit strukturieren

- Local vs. Cloud Processing: Je nach Sicherheitsanforderungen

Zukunftsausblick: Emerging Technologies

AI Agent Frameworks

Frameworks wie LangChain, AutoGen und CrewAI ermöglichen komplexe Workflows mit mehreren AI-Agenten [28, 29]:

- Automatische Code-Generierung

- Testing und Deployment

- Dokumentation

- End-to-End Automation

Agentic Development wird wichtiger, wo AI-Agenten autonom komplexe Entwicklungsaufgaben übernehmen – von der Anforderungsanalyse bis zur Produktionsbereitstellung [30, 11].

Model Context Protocol (MCP)

MCP entwickelt sich zum Standard für AI-Tool-Integration [31, 32]. Es ermöglicht nahtlose Verbindungen zwischen:

- AI-Modellen

- Entwicklungstools

- Datenbanken und APIs

- CI/CD Systems

Die Integration von Jira, GitHub und anderen Tools in einen kohärenten AI-Workflow wird zunehmend automatisiert31.

Fazit: Deine Action Items

Das erfolgreiche Programmieren mit neuen Frameworks trotz veralteter LLM-Trainingsdaten erfordert einen systematischen, multi-layered Ansatz.

Deine nächsten Schritte:

- Investiere in RAG-Infrastruktur: Setze eine Vector-Database für deine Framework-Dokumentation auf (starte mit ChromaDB)

- Nutze moderne AI-Tools optimal:

- Claude Projects für Repository-Integration

- Cursor für Codebase-Intelligence

- GitHub Copilot für Daily Workflows

- Implementiere robuste Testing: Automatisierte Validierung ist essentiell für AI-generierten Code

- Etabliere Feedback-Loops: Kontinuierliche Verbesserung des AI-Workflows durch systematisches Feedback

- Plane für Skalierung: Context Management und Performance-Optimierung von Anfang an mitdenken

💡 Wichtigste Erkenntnisse

Die Zukunft der Softwareentwicklung wird von der intelligenten Integration zwischen menschlicher Expertise und AI-Capabilities geprägt sein. Entwickler, die diese Techniken beherrschen, werden erhebliche Produktivitätsvorteile erzielen und gleichzeitig die Qualität ihrer Software verbessern.

Die kontinuierliche Weiterentwicklung von AI-Modellen, RAG-Technologien und Entwicklungstools wird diese Workflows weiter verbessern. Bereits heute ist es möglich, mit neuen Frameworks hochproduktiv zu arbeiten – vorausgesetzt, Du wendest die richtigen Strategien und Tools an.

Referenzen

Letzte Aktualisierung: Oktober 2025 | Alle Links wurden zum Zeitpunkt der Veröffentlichung überprüft

SEO-Keywords: AI-gestützte Entwicklung, RAG-Systeme, LLM Programming, Context Engineering, Claude Projects, Cursor IDE, GitHub Copilot, Framework Development, AI Code Generation, Vector Databases, Prompt Engineering, AI Agents

[1]: Zen van Riel (2024). „The Hidden Knowledge Gap Problem Undermining AI Development Tools“. zenvanriel.nl

[2]: Wikipedia Contributors (2024). „Retrieval-augmented generation“. en.wikipedia.org

[3]: AWS (2024). „What is Retrieval-Augmented Generation?“. aws.amazon.com

[4]: GeeksforGeeks (2024). „What is Retrieval-Augmented Generation (RAG)?“. geeksforgeeks.org

[5]: Tiger Data (2024). „A Beginner’s Guide to Vector Embeddings“. tigerdata.com

[6]: AI Multiple (2024). „Open Source Vector Databases“. research.aimultiple.com

[7]: Code Conductor (2024). „Context Engineering“. codeconductor.ai

[8]: Codecademy (2024). „Context Engineering in AI“. codecademy.com

[9]: Microsoft (2024). „Context Engineering Guide – Visual Studio Code“. code.visualstudio.com

[10]: Coding Scape (2024). „Best LLMs for Coding: Developer Favorites“. codingscape.com

[11]: Shakudo (2024). „Best AI Coding Assistants“. shakudo.io

[12]: Anthropic (2024). „Using the GitHub Integration“. support.claude.com

[13]: Reddit Community (2024). „Claude Pro Projects and GitHub Integrations Discussion“. reddit.com/r/ClaudeAI

[14]: n8n Blog (2024). „Best AI for Coding“. blog.n8n.io

[15]: Apidog (2024). „Codex vs Claude Code vs Cursor vs Copilot“. apidog.com

[16]: JetBrains (2024). „AI Assistant“. jetbrains.com

[17]: Tely.ai (2024). „Best Practices for Using LLM for Code Generation“. examples.tely.ai

[18]: VirtusLab (2024). „Providing Library Documentation to AI“. virtuslab.com

[19]: Zapier (2024). „Vector Embeddings Explained“. zapier.com

[20]: Simon Willison (2025). „Using LLMs for Code“. simonwillison.net

[21]: Supercharge (2024). „AI Prompt Engineering Best Practices“. supercharge.io

[22]: PromptLayer (2024). „Version Control for AI“. blog.promptlayer.com

[23]: DagsHub (2024). „Mastering Version Control for ML Models“. dagshub.com

[24]: Reddit Community (2024). „Maintaining Code Quality with Widespread AI“. reddit.com/r/SoftwareEngineering

[25]: The Momentum (2024). „AI Coding Tools in Production: What Actually Works“. themomentum.ai

[26]: Lee Conlin (2024). „Why I Stopped Using an AI Coding Assistant“. leeconlin.co.uk

[27]: Programmer.ie (2024). „RAG Systems and Performance“. programmer.ie

[28]: EdStellar (2024). „AI Agent Frameworks“. edstellar.com

[29]: Ampcome (2024). „Top 7 AI Agent Frameworks in 2025“. ampcome.com

[30]: AI Coding Tools (2024). „AI Coding Tools Blog“. aicodingtools.blog

[31]: Dev.to (2024). „A Week with Claude Code: Lessons, Surprises, and Smarter Workflows“. dev.to

[32]: YouTube (2024). „Model Context Protocol Tutorial“. youtube.com